Avez-vous déjà eu une chanson vraiment coincée dans votre tête, et vous ne savez pas avec certitude d’où vous avez entendu cette mélodie ? Ou peut-être que vous ne connaissez pas les paroles parce que ce n’est pas dans votre langue ? Eh bien, un nouveau modèle d’intelligence artificielle créé par une étude entre l’Université d’Osaka et Google pourrait peut-être vous aider à l’avenir.

Tel que rapporté par MusiqueRadardes chercheurs de Google et de l’Université d’Osaka ont réalisé une avancée intrigante en étant capable de créer de la musique en utilisant uniquement votre activité cérébrale.

Dans une étude décrite dans Brain2Music : Reconstruire la musique à partir de l’activité cérébrale humaine, les participants ont écouté des extraits de musique de dix genres différents, dont le rock, le classique, le métal, le hip-hop, la pop et le jazz, tandis que les chercheurs ont utilisé des IRM fonctionnelles (IRMf) pour mesurer leur activité cérébrale. Une IRMf mesure de petits changements dans le flux sanguin qui se produisent au fil du temps avec l’activité cérébrale, contrairement aux lectures IRM qui ne nous montrent que la structure anatomique. Grâce à l’utilisation de ces lectures, un réseau de neurones profonds a été formé pour découvrir des schémas d’activité cérébrale liés à des éléments musicaux, notamment l’humeur, le genre et l’instrumentation.

De plus, les chercheurs ont inclus les MusiqueLM modèle, un autre système Google AI, dans leur enquête. Basé sur des descriptions textuelles, MusiqueLM crée de la musique dans n’importe quel genre, en tenant compte d’éléments comme l’instrumentation, le rythme et les émotions.

Les données IRMf et les MusiqueLM base de données ont été combinées par le modèle d’IA pour reconstruire la musique que les sujets de test avaient écoutée en fonction du contexte de leur activité cérébrale. Les exemples fournis par l’équipe montrent comment des fragments musicaux qui sonnent remarquablement similaires ont été traduits par Brain2Music sur la base des ondes cérébrales des participants.

Bien que l’IA ne soit pas tout à fait prête à enregistrer des morceaux méticuleusement orchestrés, ce moment n’est peut-être pas trop éloigné. Les utilisations de Brain2Music sont nombreuses et fascinantes, bien que selon leurs chercheurs « la technologie de décodage décrite dans l’étude ne soit pas susceptible de devenir pratique dans un avenir proche ».

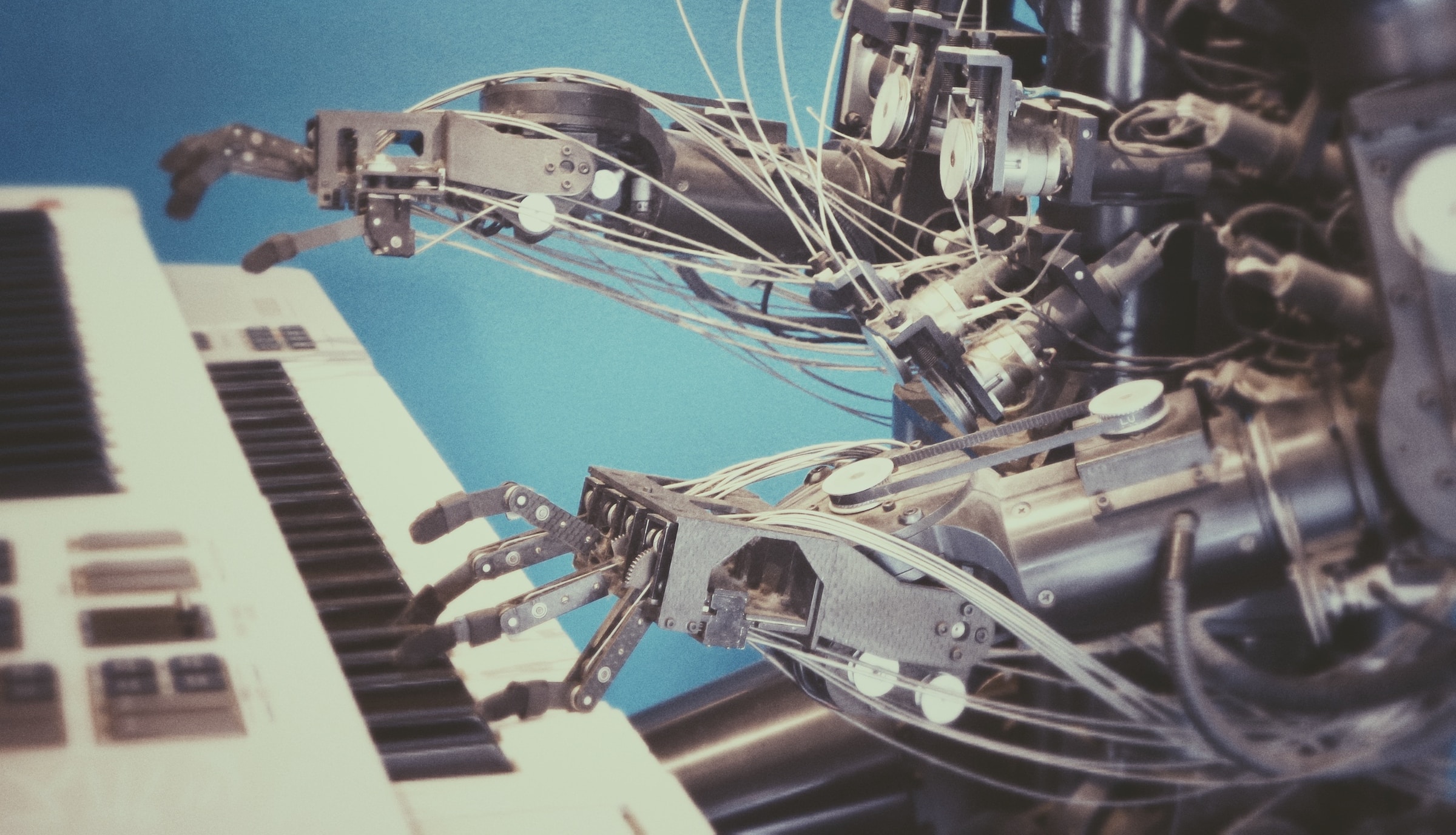

Au fur et à mesure que l’IA se développe, le potentiel de changement du processus de création musicale se développe également. Au fil du temps, les compositeurs pourront se connecter à un modèle d’IA, penser à un air, ou plusieurs, tandis que ce modèle, ou même un modèle plus sophistiqué, génère automatiquement une partition.

Vous voulez plus de métal ? Abonnez-vous à notre newsletter quotidienne

Entrez vos informations ci-dessous pour obtenir une mise à jour quotidienne avec tous nos titres et recevoir la newsletter The Orchard Metal.